人工知能(AI)の利活用が社会全体に広がるなか、リスクに対する関心が国際的に高まっている。特に採用や賃金評価など人の人生を左右することもある人事労務の領域は、欧州規制でも「ハイリスク」と位置づけられ、雇用差別の助長なども懸念されている。その是非をどう考えるか。「AIの活用自体を諦めるべきではない」と話すのは、AIガバナンス協会の佐久間弘明事務局長だ。「業務効率化だけでなく、逆に人事施策での公正性の確保やより良い人材の発見・育成に役立てることも可能です。大事なことは、AIのリスクを的確に認識した上で、メリットを引き出すためのルールや運用体制を構築すること」だという。詳しく話を聞いた。

■「誰も説明責任を果たせない」リスクも

経済産業省でデジタルプラットフォーム取引透明化法の策定などのAI・データに関わる制度整備に従事したのち、Bain&Coを経てAIリスク管理のスタートアップ、Robust Intelligenceに参画。同社の買収まで、諸業界の企業のAIガバナンス構築支援を担当。並行して立ち上げたAIガバナンス協会では、産業界の行動目標の策定や政策提言の取りまとめなどを行う。東京大学学際情報学府にて、社会学の視点でのAI倫理の研究にも取り組む。

――人事労務のAIリスクをどう捉えればよいでしょうか。

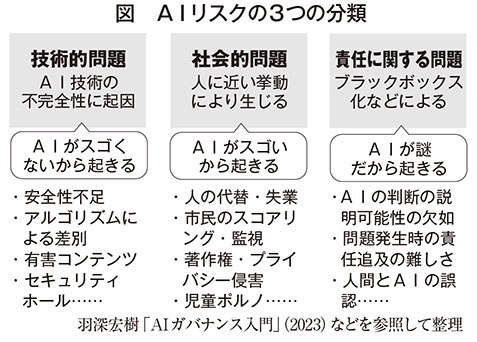

AIのリスクは、大きく3つに分けて考えることができます(下図)。まずAIが不適切な出力を行うために起きる「技術的問題」です。例えば米アマゾンでは、採用応募者の評価にAIを導入しようとしたところ、男性が多数を占める過去の応募者のデータをもとにAIが学習したことで女性応募者を低評価するバイアスが反映されてしまい、2018年にシステムの運用を中止しました。AIの技術的な欠陥が雇用差別として顕在化した事例です。また、最近では攻撃への脆弱性も明らかになっており、逆に応募者の側が応募書類に特殊な加工をして採用AIから高評価を引き出すといった問題も報告されています。

次に、AIが優秀であるがゆえに起きる「社会的問題」があります。例えば、AIが人の業務を代替することによる失業が代表的な例です。また最近では生成AIによる著作権侵害や、実在の人間を精巧に再現できてしまうことによるプライバシーの侵害、児童ポルノの生成なども深刻な社会的問題になっています。

最後に、AIによる判断のプロセスがブラックボックス化することによる「責任の問題」です。特に人事評価などに活用する際に問題化しやすいリスクです。例えば日本IBMでは、19年に人事評価AIを導入し給与調整に活用していましたが、評価の基準や理由が不透明である点などについて労働組合が説明を要求。東京都労働委員会への救済申立を経て今年8月、全40項目の評価基準を会社が組合に開示し、減額や低評価の際などに理由の説明を行うといった和解が成立しました。AIが優秀になればなるほど、従業員だけでなく評価する側のマネージャーもそれに依存してしまい、誰も説明責任を果たせなくなるといったリスクも想定され得るでしょう。

――人事労務の現場では様々なHRテックも活用されていますが、リスクが高いかをどう判断すればよいのでしょうか。

紙での管理を電子化して共有するといった技術から、人事評価や採用判定まで幅広いHRテックがあり、すべてリスクが高いというわけではもちろんありません。判断のポイントは、AIの判断が何に使われ、対象者にどのような影響を与えるかです。

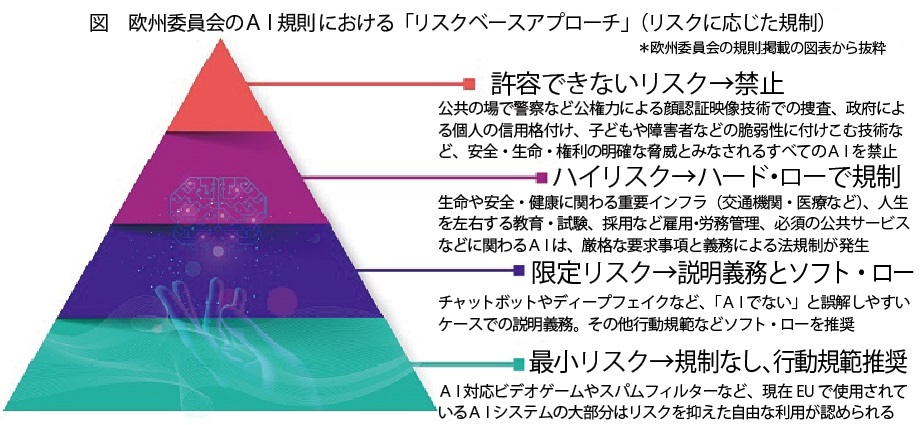

今年8月から段階的に施行されているEUのAI規則では、人生を左右する採用など雇用・労務管理を、4段階のリスクレベルの上から2つめの「ハイリスク」に指定し、厳格な要求事項と義務的法規制を課しています。

例えば職場において、採用の判定や賃金の査定など応募者や従業員の人生を左右するような判断にAIなど自動化ツールを活用しているような場合は、ハイリスクと認識する必要があるでしょう。

ただし、ハイリスクだから必ずしも活用を諦めるべきということではありません。慎重なプロセスや多層的なリスク対策を行うことで、逆に無意識の差別やバイアスを除去したり、人間では感知できないレベルの精密な判断に役立てることもできます。

日本では、政府検討会で岸田首相(当時)が法規制に言及するといった動きもあるものの、現状はソフトローによる規制のもとAI提供者や企業の自主的な取組みに任されている部分が大きくなっています。ただEUをはじめとした国際的な規制の流れも無視できないですし、何より企業自身にとって、AIのリスクを的確に認識してその価値を引き出す「AIガバナンス」は、特に人事労務領域でも今後必須になっていくと考えています。

■多層的な対策、各企業で構築を

この情報へのアクセスはメンバーに限定されています。ログインしてください。メンバー登録は下記リンクをクリックしてください。