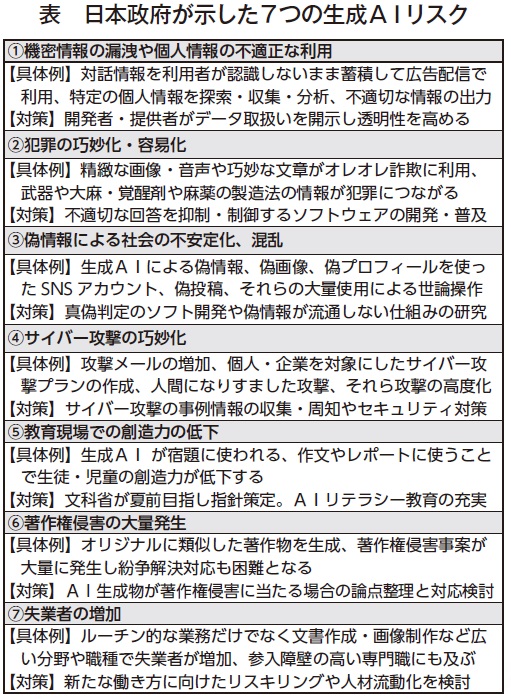

人工知能(AI)の利活用に関するルールなどを議論する政府の「AI戦略会議」がこのほど開かれ、生成AIの利用で懸念される7つのリスクの具体例(表)などをまとめた「論点整理」が示された。日本政府は生成AIの活用に積極的な姿勢を示す一方、5月に開かれた先進7カ国(G7)サミットでは「信頼できるAI」の共同声明を採択。官民での活用に向けて急務となる規制のあり方や、事業者のガバナンス構築に向けて、先行する欧州での議論も参考となりそうだ。

■ハード・ローとソフト・ローの組み合わせで

今年の4月以降、大和証券やソフトバンクでは全社員を対象に「チャットGPT」を業務に活用すると発表し、日立製作所では生成AIの専門組織「ジェネレーティブAIセンター」を設立するなど、生成AIを利活用する動きは民間企業の間でも大きくなりつつある。

AI戦略会議がまとめた論点整理のなかでは「AI の勃興とともに再び成長の機運が見えており、諸外国の後塵を拝さないよう、今こそ大胆な戦略が必要」とやや前のめりな姿勢も見られるが、「開発・提供・利用を促進するためにも、生成AIの懸念やリスクへの適切な対応を行うべき。いわば、『ガードレール』の設置が必要」と整理した。

具体的には、AI開発者・サービス提供者と企業や個人などのサービス利用者ごとに分けて整備するべきと指摘。AI開発者・提供者は、まず既存の法令やガイドラインの遵守を促すことが重要とし、それだけで対処が難しい場合には、法令などハード・ローと民間の自主的な取り決めなどソフト・ローとを組み合わせた規制のあり方を示唆した。またサービス利用者については、リスクの明確化やAIリテラシー向上の取組みを講じるべきとした。

リスクについては、表にあげた7点について具体例や対策とともに詳細に例示。AIの利用促進に関し、ものづくりや金融、医療といった産業の事業者について、AIを利用することで事業変革に結びつけられるニーズが高い点にも言及した。

■欧州は4段階でAI規制、採用は「ハイリスク」

この情報へのアクセスはメンバーに限定されています。ログインしてください。メンバー登録は下記リンクをクリックしてください。